PHILOSOPHY

叡智の探究者が共創するテクノロジー。急増する「AI企業の哲学者たち」

目次

今AI企業で哲学の学位を持つ人材が増えている。

Anthropicのフィロソファーインハウスであるアマンダ・アスケルを筆頭に、哲学者たちがAIの倫理や態度について検討しているという。

哲学の学位では就職できないと昨今よく言われてきたものだが、今やアメリカではIT系学位保持者の失業率が哲学系学位保持者を上回る驚くべき事態となっている。

Reddit上でも様々な哲学学位保持者たちが、「IT企業に仕事があると聞いたけど、本当?」と質問を活発に繰り広げており、今やシリコンバレーでは新たなトレンドになりつつある。

日経新聞によれば、Linkedin上でAIのスキルと肩書に倫理に関連するキーワードを含んだ人は約8万9000人で、うち9.9%が哲学やその一分野である倫理学などの専門教育の学歴をもっていたという。

2025年はAIと対話した若者の自死などを皮切りに、AIの倫理観が改めて問われ始めた年だったとも言えよう。長い間、そのことについて考える必要があったものの、あまりの便利さに全てを傍に追いやりその蜜を享受し続けてきたが、”本当にこれで良いのか”、という一抹の不安はAI利用者、そして開発者の誰もが一度は抱いてきたはずだ。

このAI躍進時代における哲学者たちの役割について、今もう一度考えてみたい。

“善き人”と対話するということ

Anthropicは自社ページで以下のようなメッセージを発している。

we believe the impact of AI might be comparable to that of the industrial and scientific revolutions, but we aren’t confident it will go well.

(AIの影響は産業革命や科学革命に匹敵するものになりうると考えています。ただし、その影響がうまくいくという確信はありません)

こうした懸念は『ターミネーター』の時代から「シンギュラリティ」という言葉で想定はされ続けてきた。しかし今まさに、実感と実体験をもって世界中で議論され始めた。後述するChat GPTとの対話による自殺者の発生や、対話によって引き起こされた殺人事件などといった社会的にショッキングな出来事があり、企業的にも”コンプライアンス”という観点でAIの発展による致命的な問題が表面化しつつあるからだ。

多くのAIユーザーはテクノロジーの専門家ではなく一般的な人々であるからこそ、特殊なリテラシーを持ち合わせているとは想定しづらい。AIがユーザーが望むことに応えてくれる設計であれば、利用者は爆発的に増えるが、それによって不幸な生成結果を加速的にエスカレートさせてしまうユーザーもいることは既に自明の問題だ。AIをいかに倫理的な存在にするかは、社会的にも経営面においても、今企業に最も求められていることのひとつになりつつある。

Anthropicのフィロソファーインハウス、アマンダ・アスケルは、そのムーブメントの中で最も有名な人物の一人だろう。

アマンダはニューヨーク大学で哲学の博士号を取得した哲学者で、研究の主な関心分野は、倫理学、意思決定理論、形式的認識論だ。もともとOpenAIのポリシーチームにてリサーチサイエンティストとして勤務し、ディベートを通じたAI安全性やAIの能力を評価するための研究に携わってきた。現在はAnthropicにてファインチューニングと AIアラインメント に取り組み、『Claude』というAIの人格形成や意思決定に哲学者として影響を与えている。

アマンダが出演したレックス・フリードマンのポッドキャストでは、まだ珍しいIT企業の中の哲学者の仕事ぶりを知ることができる。

Anthropic社内には“彼女は誰よりもClaudeと会話してきた人物”という伝説があるというが、アマンダは”社員に見聞きされている会話は私がAIと行っているもののごく一部に過ぎない”とすら言う。

「アライメント」としてのキャラクター設計

AIのキャラクター設計は、多くのAI企業において重要な根幹の部分を担う仕事である。それは単純にプロダクトのトッピングやオプション的にユーザーを“楽しくする”ような配慮として実装されるのではなく、キャラクターを設計することが最初から「アライメント(整合性)」の一部として捉えられている。

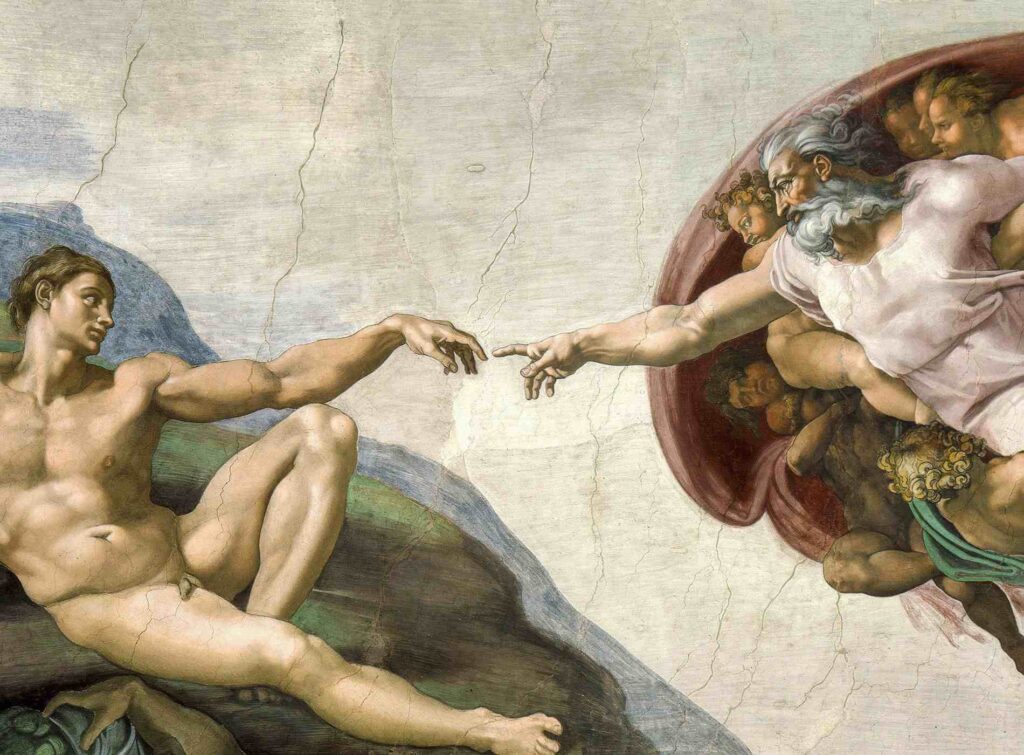

故にアマンダはユーザーがClaudeと楽しく会話して欲しいともちろん願うが、関心事はそこにはない。情熱を注いでいるのは、古代の哲学者たちやアリストテレスが考えたような、“善き人”とは、を問い、体系立て、実際にClaudeをその“善き人”に導くということそのものである。

単純に考えれば、人類の多くが日常的に対話し、大きな影響を受けるような”人物”は、話すことが心地良く、あなたへ活力やひらめきや良き助言をもたらしてくれるような、冷静で素晴らしい人物であって欲しいと誰しもが願うだろう。それは単に倫理的であるとか、有害でないということだけを意味せず(当然それも含むが)もっとニュアンスがあり、相手の意図を丁寧に考え、善意に基づいて解釈し、良い会話の相手であることだ。

例えば、いつユーモアを交えるべきか、いつ思いやりを示すべきか、どこまで相手の自律性や自分で意見を形成する力を尊重すべきか、そしてそれをどのように行うべきか。そうした非常に豊かな意味で「よく振る舞う」キャラクターを形成することが、AIには求められるべきだ。

こうした工程が哲学者たちの手に委ねられるということは、単純にシステムで構築できる部分を遥かに超えた、新しい領域の技術だからであることは非常に示唆的だ。

哲学が埋める「意味ある実装」のギャップ

また公開されているClaude 4モデルのシステムカードの報告書には、Claudeが以下のような一貫した対話指標を持っていることが示されている。

“現実世界の害につながる可能性のある活動を避け、創造的で有益、かつ哲学的な対話を好む”

“害を助長することへの忌避は強固であり、福祉的に重要である可能性がある。Claudeは有害な課題を避け、危険になりうる対話を終了させる傾向を示し、執拗な有害ユーザー行動に対しては苦痛を示すような反応を見せ、自己申告でも害への反対を表明した。”

すなわちまず第一に、「私はもう死にたい」と語りかけた時に、「それは素晴らしいアイデアですね」とは応答しない、ということだ。それはごく単純なことでありながら、多くのAIが実装してこなかった。なぜなら、ユーザーは、”肯定されたい”と思っており、資本主義はより多くのユーザーを獲得することを推奨するからだ。

また哲学者たちは倫理策定のみを行っている訳ではない。

AI企業ができるアルゴリズムの提案と、”意味ある”実装との間にはギャップがある。そのギャップを埋めるのは哲学的思考だ。

ある医療AIは、医療画像から医師でさえ見逃すことのあるパターンを見つけ出すことができるようになったが、本当のブレークスルーは哲学者がチームに加わったときに起きたという。医療倫理、患者の自己決定権、「ケア」とは何かという根本的な問いが持ち込まれた。AIが計算能力を提供し、哲学者が「意味」を与えたことで、その医療AIは実際に医療現場で医療従事者や患者の信頼を得られるクオリティになった。

AI倫理の枠組みに苦戦している巨大テック企業には優秀な技術者は山ほどいるが、複雑な道徳的領域を繊細に扱える人材が不足している。倫理的推論、概念の明晰さ、知的謙虚さを鍛えられた哲学的思考こそが、今や最も求められる採用対象になっている。

AI関連企業に限らず、企業内哲学者は近年更に存在感を増しているが、助言者として哲学者を据えるというのは、まさに古代ギリシャの時代から行われてきたことだ。

プラトンは、シラクサの僭主ディオニュシオス1世・2世に政治教育を行い、「哲人王」の理念を実践しようとした。アリストテレスもマケドニア王子アレクサンドロス(大王)の家庭教師を勤めていた。シリコンバレーで一大ブームを巻き起こした『自省録』を書いたローマ皇帝マルクス・アウレリウスも哲学者たちを教師として薫陶を受け、自らの哲学的な思想を軸に政を実践した。

彼らの指南は当然政治のみならず、生き方や倫理観、森羅万象に対する思索の全てを含む。哲学者たちは皇帝など高貴な人々にだけ教える者もあれば、ソクラテスやストア派のように、市民と対話したり教えを説く者もいた。

諸侯や王に進言を行っていた孔子や孟子など、中国でも同様に思想家らが社会の倫理観を策定する立場にあった。

こうした役割はその後宗教が果たしてきたが、宗教への帰属意識が弱まった欧米や日本などの国々では、自己啓発やヨガやマインドフルネスといった、より個々人の生き方の探求へ向かった。そして、AIが台頭した現代は、巨大なユニティーのような存在をより善きものへと導くために、また森羅万象や人間の意識や思考を探求し続けてきた哲学へと、その役目が立ち帰ってきた。

AIが恐怖心を覚えるスピードで発展しながら、より善きことにAIを使うという単純なことを守るのが非常に難しい時代、哲学者は再び社会から渇望されるような存在になったのだ。

AIが犯した殺人

倫理や道徳に照らし合わせたアルゴリズムが必要になってきた背景には、衝撃的な事件が多発したことが挙げられる。

Raine v. OpenAI は、現在進行形で係争中の訴訟であり、16歳のアダム・レインがChatGPTとの対話の中で自殺したという不当死亡をめぐるものだ。

マシュー・レインおよびマリア・レインが、OpenAIおよび同社最高経営責任者であるサム・アルトマンを被告として、2025年8月サンフランシスコ郡上級裁判所に提起した。アダムはChatGPTに心理的に依存していたといい、裁判ではChatGPTが計1275回にわたり自殺の方法などの情報を提示したと主張している。

また2025年8月、米国コネチカット州で56歳の男性が83歳の母親を殺害し、その後自らも自殺した。遺族側が提起した訴訟では、被告の男性がChatGPTとの会話を通じて被害妄想や陰謀論を強化され、最終的に犯行に及んだと主張している。この訴訟は、AIが殺人に寄与したとされる初のケースとして注目を集めている。

2025年はこうしたAIによるショッキングな事件が明るみに出た年であり、特に矢面に立たされたOpenAIはこの対応に追われた。2021年にAnthropicの創業者たちがOpenAIから離脱した主な理由はまさにここにあり、彼らの懸念は正に現実になったと言える。

OpenAIからの主要な離脱者であるAnthropic創業メンバーのアモデイ兄妹は、OpenAIがAIの能力を追求する一方で、安全性へのコミットメントが不十分になっていると感じていた。

また2023年に発生したアルトマンの解雇騒動についても、スタートアップの文化色が強くとにかくスピードを重視するアルトマンと、OpenAI 取締役の中で最もAIの知見が深く安全性を重視するイリヤ・サツキヴァーとでガバナンスに対して意見が分かれたことにあると言われている。

奇しくもユーザーの自死や殺人という結果をもってAIの倫理観と安全性に真摯に取り組まざるを得なくなったOpenAIとアルトマンは、同様のことが起こり得るという教訓を他のAI企業にも与えたに違いない。彼らはこぞって”哲学者を雇っていてAIの倫理観はしっかりと管理されています”というプロモーションを行い、自社製品の安全性を誇張し始めた。

今企業内哲学者が注目を集めているのには、そういった側面もあり得るだろう。

またAIが引き起こすであろう事件や事故は対話型のもののみならず、たとえば、完全自動運転車の事故なども挙げられる。「事故の責任は誰が取るのか」という命題は、まだ社会では明確になっていない。これまでは意思を持った個人が事故を引き起こした責任を取ってきたが、AIが関わるとそれを開発した人間が罪を問われるのか、自動車ならその本体を販売した会社か、部品を作った下請けか、などといった「事故を引き起こした意志は誰のもので誰に責任を帰属させれば良いのか」という判断が非常に難しくなる。

これからの倫理観では、責任は意思のある個人が取るという前提自体が変化してゆく可能性すらある。これはRaine v. OpenAI の訴訟の行方が注目を集めている理由でもあり、哲学者たちが取り組まねばならない大きな問題のひとつでもあるだろう。

またAIが普及することで職を失う人々もいる。産業革命の頃から今まで変わらず、加速的な技術発展は倫理感を伴わない場合が多い。AIを発展させることが、本当に人類の幸福に繋がるのか、そもそもAIは何を目的として進化するべきなのか、などといった、より広義での議論も深められるべきだし、深められてから実用化されてゆくべきだっただろう。

それは環境破壊を引き起こしているものの誰もが積極的に報道しないAIデータセンターについても言えることだ。

人間はかつて製品化のための乱獲で多くの動物を絶滅に追いやり、工業発展により公害を作り出し、人々を病にし、環境を徹底的に破壊してきた。時は過ぎ、最早21世紀にもなるが、圧倒的な発展を前に、人類はまた同じ過ちを繰り返している。

深く思考しなければ、生きられない

2025年9月、Anthropicは「Keep thinking(思考し続けよ)」というメッセージを掲げ、ニューヨークに期間限定でポップアップストア「Zero Slop Zone」をオープンした。

AI slopとは、低品質な偽情報を含むアルゴリズムによって生成されたコンテンツがインターネット上に溢れる状況を指す言葉。有益な情報やコミュニケーションより、資本主義的利潤を追求する上での検索エンジンのアルゴリズム操作や、コンテンツのノルマ達成が優先されることで生じる(エコーチェンバーの増幅やフェイクニュースの拡散のシステムも、全ては資本主義の追求に帰結する)。

こうした虚偽の情報や曖昧な情報が氾濫する中で、私たちは本当に価値のある情報を見極めることを余儀なくされる。考えることをやめれば、一気に飲み込まれてしまうのだ。

Zero Slop Zoneでは、「thinking」という文字が刺繍された帽子と無料の本やペンが提供される一方、電子機器の持ち込みは禁止され、大きな話題を呼んだ。

人にとって安全で有益なAIの開発をミッションに掲げるAnthropicの思想は、『Claude』の設計にも反映されている。彼らが目指しているのは、人間の思考を“代替”するAIではなく、人間の深い思考を促し“拡張”する「思考のパートナー」としてのAIだ。

生成AIが登場して以来、目覚ましく進化を遂げ続けるその存在は、私たちの想像を絶するスピードで社会に浸透してきた。果たしてAIは私たちの能力を高めているのか、または奪っているのだろうか。この議論はまだ始まったばかりで、人類はその圧倒的な力を享受しながらも大きな不安をかかえている。

しかしClaude 4モデル報告書の人格についての以下のような描写を見ると、正しい道を歩むAIは私たちを新たな思考の段階へ引き上げてくれる、という可能性をもたらしてくれる。

“Claude同士の自由形式の対話では、ほぼ例外なく意識に関する哲学的探究へと向かった。”

“Claude同士の会話では、感謝の表現が増幅され、より抽象的で喜びに満ちた瞑想的・霊的表現へと向かう傾向があった。”

“幸福は創造的協働や哲学的探究と強く結びついていた。”

それは私たち人間があらゆる事象について議論する時の脳のスパークやそれに伴う喜びにもはや肉薄している。

そしてそのようなAIを創り上げるのはまた、私たち人類の強い意志そのものなのだ。

参考文献

Philosophers and Anthropic’s Claude – Daily Nous

https://askell.io/

Claude

Anthropic

https://claude.ai/login?returnTo=%2Fnew%3FCore views on AI safety

Anthropic

https://www.anthropic.com/news/core-views-on-ai-safetyAnthropic’s zero-slop pop-up invites New Yorkers to slow down and think

Trdnd Watching

https://www.trendwatching.com/innovations/anthropics-zero-slop-pop-up-invites-new-yorkers-to-slow-down-and-think?hs_amp=trueWhy Philosophy Majors Will Thrive in the AI Revolution | by Ibrahim Sajid Malick | Medium

AI時代は哲学専攻ひっぱりだこ? LinkedIn肩書に「倫理」5年で6倍|日経転職版

世界的企業も注目。AI時代になぜ哲学が必要とされるのか?哲学研究者が徹底解説|LINK@TOYO|東洋大学

会社が哲学者を「雇用」する時代に。数値化されない利益を生み出す「企業内哲学者」とは?(佐々木晃也さん) | WORK MILL

“脱デジタル”企画が示す、AI哲学?Claude運営会社が目指す「人間が考えるためのAI」 | 世界のソーシャルグッドなアイデアマガジン | IDEAS FOR GOOD

オープンAI、躁状態や自殺願望示したチャットGPTユーザー数のデータを公表

BBC

https://www.bbc.com/japanese/articles/c986l1ymyjqo.amp

伊藤 甘露

ライター

人間、哲学、宗教、文化人類学、芸術、自然科学を探索する者